تقول الحكمة التقليدية: "إذا كنت لا تريد أن يتم استخدام بياناتك، فانسحب من كل شيء".

نحن نقول: "إذا تم جمع بياناتك على أي حال، فمن الأكثر عقلانية التأثير على كيفية استخدامها".

ليس السؤال هو: "هل يجب أن تمتلك الشركات بياناتي؟" (فهي تمتلكها بالفعل).

السؤال الحقيقي هو: "هل يجب أن تساهم بياناتي في بناء ذكاء اصطناعي أفضل للجميع؟"

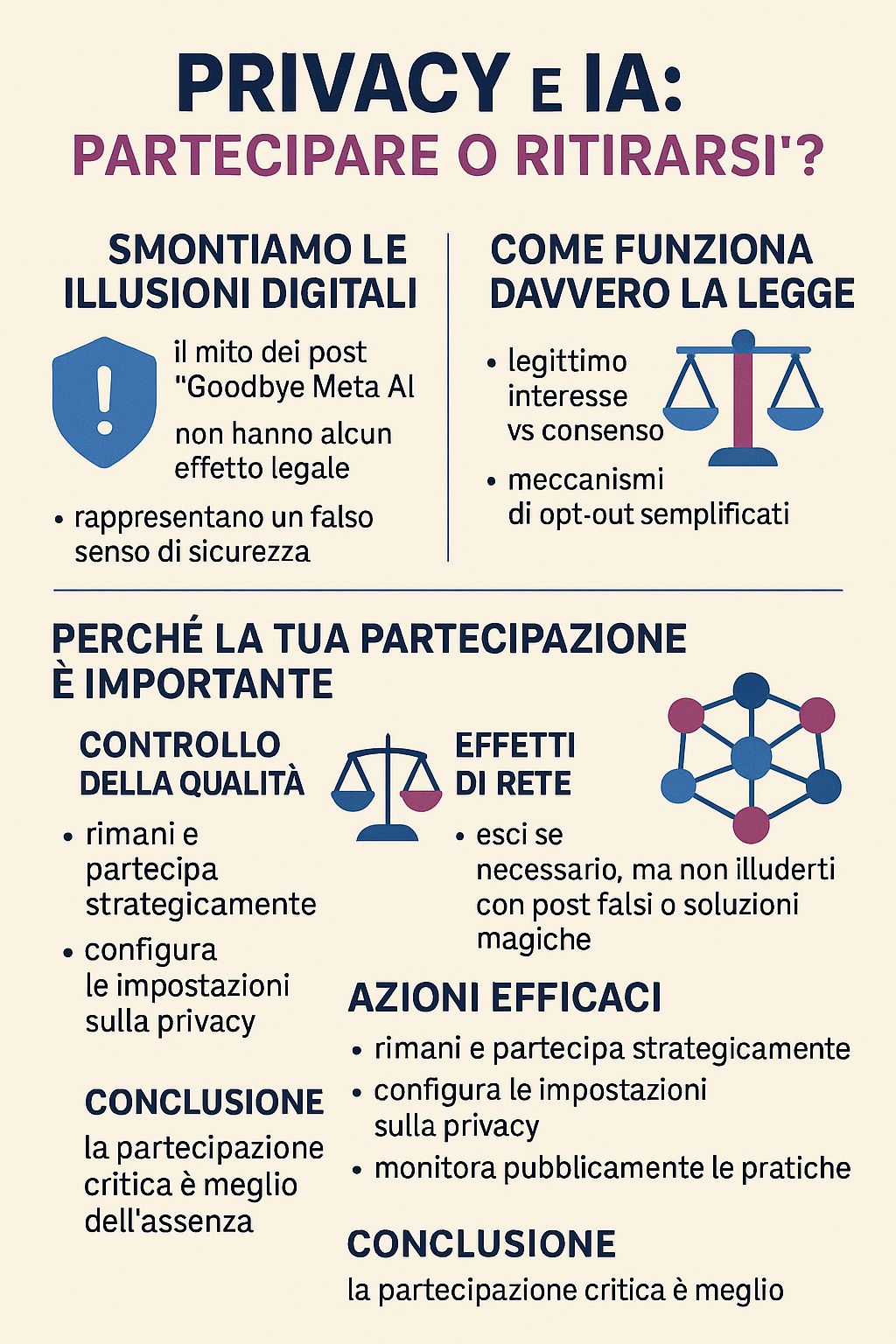

قبل بناء حجة جادة، من الضروري تفنيد الوهم الخطير الذي ينتشر على وسائل التواصل الاجتماعي: المنشورات الفيروسية "Goodbye Meta AI" التي تعد بحماية بياناتك بمجرد مشاركة رسالة.

الحقيقة المزعجة: هذه المنشورات مزيفة تمامًا ويمكن أن تجعلك أكثر عرضة للخطر.

كما أوضحت Meta نفسها، "مشاركة رسالة "وداعًا Meta AI" لا تشكل شكلاً صالحًا من أشكال المعارضة". هذه المنشورات:

النجاح الهائل الذي حققته هذه المنشورات يكشف عن مشكلة أعمق: نحن نفضل الحلول البسيطة والوهمية على القرارات المعقدة والمستنيرة. إن مشاركة منشور ما تجعلنا نشعر بأننا نشارك بنشاط دون الحاجة إلى بذل جهد لفهم كيفية عمل حقوقنا الرقمية.

لكن الخصوصية لا تدافع عنها الميمات. إنها تدافع عنها المعرفة والعمل الواعي.

اعتبارًا من 31 مايو 2025، طبقت Meta نظامًا جديدًا لتدريب الذكاء الاصطناعي باستخدام "المصلحة المشروعة" كأساس قانوني بدلاً من الموافقة. هذه ليست ثغرة قانونية، بل أداة قانونية ينص عليها القانون العام لحماية البيانات (GDPR).

المصلحة المشروعة تسمح للشركات بمعالجة البيانات دون موافقة صريحة إذا تمكنت من إثبات أن مصلحتها لا تغلب على حقوق المستخدم. وهذا يخلق منطقة رمادية حيث "تقوم الشركات بتكييف القانون" من خلال تقييمات داخلية.

استخدام البيانات غير المجهولة الهوية ينطوي على "مخاطر عالية من انعكاس النموذج، وتسربات التخزين، ونقاط الضعف في الاستخراج". القوة الحاسوبية اللازمة تعني أن الفاعلين ذوي القدرات العالية فقط هم من يمكنهم استغلال هذه البيانات بفعالية، مما يخلق تباينات نظامية بين المواطنين والشركات الكبرى.

الآن بعد أن أوضحنا الواقع القانوني والتقني، دعونا نبني حجة المشاركة الاستراتيجية.

عندما يستسلم الأشخاص الواعون، تتدرب الذكاء الاصطناعي على من يبقى. هل تريد أن تعتمد أنظمة الذكاء الاصطناعي بشكل أساسي على بيانات الأشخاص الذين:

تحدث التحيزات في الذكاء الاصطناعي عندما تكون بيانات التدريب غير تمثيلية. تساهم مشاركتك في ضمان:

تتحسن أنظمة الذكاء الاصطناعي مع التوسع والتنوع:

إذا كنت تستخدم ميزات تعتمد على الذكاء الاصطناعي (البحث والترجمة والتوصيات وأدوات إمكانية الوصول)، فإن مشاركتك تساهم في تحسينها للجميع، بما في ذلك المستخدمين المستقبليين الذين هم في أمس الحاجة إليها.

لا تتغير خصوصيتك بشكل كبير بين الاشتراك في الذكاء الاصطناعي أو إلغاء الاشتراك فيه. نفس البيانات تغذي بالفعل:

الفرق هو ما إذا كانت هذه البيانات تساهم أيضًا في تحسين الذكاء الاصطناعي للجميع أم أنها تخدم فقط المصالح التجارية الفورية للمنصة.

هذا هو بالضبط السبب الذي يجعل الأشخاص المسؤولين مثلك يجب أن يشاركوا. الانسحاب لا يوقف تطور الذكاء الاصطناعي، بل يزيل صوتك منه فحسب.

سيتم تطوير أنظمة الذكاء الاصطناعي على أي حال. السؤال هو: هل سيتم ذلك بمساهمة الأشخاص الذين يفكرون بشكل نقدي في هذه القضايا أم بدونها؟

مفهوم. لكن فكر في هذا: هل تفضل أن يتم بناء أنظمة الذكاء الاصطناعي بمساهمة من أشخاص يشاركونك شكوكك تجاه الشركات الكبرى أم بدونها ؟

عدم ثقتك هو بالضبط السبب الذي يجعل مشاركتك النقدية قيّمة.

الذكاء الاصطناعي أصبح حقيقة واقعة، سواء شاركت فيه أم لا.

خيارك ليس ما إذا كان الذكاء الاصطناعي سيتم بناؤه، بل ما إذا كان الذكاء الاصطناعي الذي سيتم بناؤه سيعكس قيم ووجهات نظر الأشخاص الذين يفكرون ملياً في هذه القضايا.

الانسحاب هو مثل عدم التصويت. إنه لا يوقف الانتخابات، بل يعني فقط أن النتيجة لن تأخذ مساهمتك في الاعتبار.

في عالم لا يستطيع فيه سوى الجهات ذات القدرات الحاسوبية العالية تفسير هذه البيانات والاستفادة منها بفعالية، فإن صوتك النقدي في التدريب قد يكون له تأثير أكبر من غيابك.

ابقَ وشارك بشكل استراتيجي إذا:

وفي غضون ذلك:

لكن لا تخدع نفسك بـ:

إن انسحابك الفردي له تأثير ضئيل على خصوصيتك، ولكن البقاء له تأثير حقيقي على الجميع.

في عالم ستحدد فيه أنظمة الذكاء الاصطناعي تدفق المعلومات والقرارات والتفاعلات بين الأشخاص والتكنولوجيا، فإن السؤال ليس ما إذا كان يجب أن توجد هذه الأنظمة، بل ما إذا كان يجب أن تتضمن وجهة نظر أشخاص مفكرين ونقديين مثلك.

في بعض الأحيان، لا يكون الاستسلام هو الإجراء الأكثر جذرية. غالبًا ما يكون الإجراء الأكثر جذرية هو البقاء والتأكد من أن صوتك مسموع.

مجهول

لا يتعلق الأمر بالثقة العمياء في الشركات أو تجاهل المخاوف المتعلقة بالخصوصية. يتعلق الأمر بالاعتراف بأن الخصوصية لا تدافع عنها الميمات، بل المشاركة الاستراتيجية والواعية.

في نظام بيئي تتسم فيه التفاوتات في القوة بضخامتها، يمكن أن يكون لصوتك النقدي في تدريب الذكاء الاصطناعي تأثير أكبر من غيابك الاحتجاجي.

مهما كان اختيارك، فاختر بوعي، لا بوهم رقمي.

فقرة تعاطف أيضًا مع "رهبان الخصوصية" - تلك الأرواح النقية التي تعتقد أنها تستطيع الهروب تمامًا من التتبع الرقمي من خلال العيش دون اتصال بالإنترنت مثل الرهبان التبتيين في عام 2025.

تنبيه: حتى لو انتقلت للعيش في كوخ نائي في جبال الدولوميت، فإن بياناتك موجودة بالفعل في كل مكان. طبيبك يستخدم أنظمة رقمية. البنك الذي تودع فيه مدخراتك لشراء الحطب يتتبع كل معاملة. السوبر ماركت في القرية لديه كاميرات وأنظمة دفع إلكترونية. حتى ساعي البريد الذي يجلب لك الفواتير يساهم في قواعد البيانات اللوجستية التي تغذي خوارزميات التحسين.

الانعزال الرقمي التام في عام 2025 يعني في الأساس الانعزال عن المجتمع المدني. يمكنك التخلي عن Instagram، ولكن لا يمكنك التخلي عن نظام الرعاية الصحية أو البنوك أو التعليم أو العمل دون أن يكون لذلك عواقب وخيمة على جودة الحياة.

وبينما تقوم ببناء كوخك المضاد لـ 5G، تظل بياناتك موجودة في قواعد بيانات المستشفيات والبنوك وشركات التأمين والبلديات ومصلحة الضرائب، وتستخدم على أي حال لتدريب الأنظمة التي ستؤثر على الأجيال القادمة.

مفارقة الناسك: عزل نفسك احتجاجًا لا يمنع تدريب أنظمة الذكاء الاصطناعي على بيانات الأشخاص الأقل وعيًا، ولكنه يحرمك من إمكانية التأثير على تطويرها في اتجاهات أكثر أخلاقية.

في الأساس، لقد حصلت على النقاء الأخلاقي النقي لمن يراقب التاريخ من المدرجات، بينما يكتب الآخرون - الأقل استنارة ولكن الأكثر حضوراً - قواعد اللعبة.

مهما كان اختيارك، فاختر بوعي، لا بوهم رقمي.

المقالات المذكورة:

مزيد من المعلومات حول اللائحة العامة لحماية البيانات والمصلحة المشروعة:

الموارد الرسمية:

للإجراءات العملية: إذا كنت في أوروبا، تحقق من الإجراءات الرسمية للانسحاب من Garante Privacy. للحصول على معلومات عامة، راجع إعدادات الخصوصية وشروط الخدمة الخاصة بمنصتك. وتذكر: لا توجد أي منشورات على وسائل التواصل الاجتماعي لها قيمة قانونية.